Может ли видеокарта заменить процессор? Мой личный эксперимент

Все началось с любопытства. Я, Иван, заядлый любитель компьютерных игр и самоделкин, задумался⁚ а что если попробовать заставить видеокарту выполнять задачи, традиционно решаемые процессором? Звучит безумно, я знаю. Но меня уже давно интриговала мощь современных GPU. Поэтому я решил провести эксперимент, изучив возможности переложить некоторые вычислительные процессы с процессора на видеокарту. Результат оказался довольно неожиданным, и я готов поделиться с вами первыми впечатлениями.

Неожиданная идея и начальные предпосылки

Идея пришла ко мне совершенно неожиданно, во время очередного затянувшегося рендеринга видео. Мой компьютер, хоть и достаточно мощный, стонал под нагрузкой, а я с нетерпением ждал результата. Глядя на мигающие индикаторы на видеокарте, я задумался⁚ а почему бы не попробовать распределить задачу по-другому? Ведь видеокарты известны своей невероятной вычислительной мощью, особенно в обработке графики. Но может ли эта мощь быть использована для задач, традиционно решаемых процессором?

Конечно, я понимал, что это не просто. Архитектура процессора и видеокарты радикально различается. Процессор, это универсальный инструмент, способный выполнять разнообразные инструкции. Видеокарта же — специализированный ускоритель, ориентированный на параллельные вычисления, прекрасно подходящий для обработки больших массивов данных, таких как пиксели в изображении. Но ведь многие задачи, вроде кодирования видео или сжатия файлов, тоже требуют обработки больших массивов данных.

Первоначально я исследовал возможности OpenCL и CUDA, фреймворков, позволяющих писать программы, работающие на GPU. Я просмотрел массу статей и туториалов, попытался понять основные принципы программирования для видеокарт. Оказалось, что это не так просто, как я представлял себе вначале. Синтаксис отличается от того, к чему я привык, а оптимизация кода для GPU требует особых навыков и знаний. Но меня это только заинтересовало еще больше. Я уже представлял себе, как мой компьютер будет летать, если удастся переложить часть нагрузки с процессора на мощную видеокарту.

Мои попытки эмуляции процессорных задач на видеокарте

Первым делом я решил попробовать запустить простую программу на обработку чисел Фибоначчи. Это классическая задача, часто используемая для тестирования производительности. Я написал программу на C++, используя OpenCL для выполнения расчетов на видеокарте. На первый взгляд все выглядело просто⁚ разделить вычисления между ядрами GPU и подождать результата. Однако реальность оказалась сложнее.

Основная проблема заключалась в передаче данных между процессором и видеокартой. Оказалось, что этот процесс занимает значительно больше времени, чем сами вычисления. Даже для относительно небольшого количества чисел время передачи данных превышало время вычислений на GPU. Я пробовал разные способы оптимизации, изменял размер блоков данных, экспериментировал с разными алгоритмами передачи, но существенного улучшения не получил.

Затем я попытался переложить на видеокарту задачу сжатия файлов. Для этого я использовал алгоритм LZ4, известный своей высокой скоростью. С помощью CUDA я написал программу, которая разделяла файл на блоки и сжимала их параллельно на GPU. Результат был более утешительным. Хотя передача данных все еще играла значительную роль, общее время сжатия уменьшилось приблизительно на 20%. Это подтвердило мою догадку, что видеокарта может быть эффективным помощником в решении определенных задач, но не полной заменой процессору.

После этих экспериментов я решил попробовать что-то более сложное. Я попытался адаптировать простой алгоритм машинного обучения для работы на GPU. Однако это оказалось задачей гораздо более сложной, требующей глубокого понимания как алгоритмов машинного обучения, так и особенностей программирования для GPU. В итоге я так и не смог добиться удовлетворительных результатов в этой области.

Результаты экспериментов⁚ неожиданные успехи и явные провалы

Результаты моих экспериментов оказались довольно неоднозначными. С одной стороны, я был приятно удивлен успехами в некоторых областях. Например, задача сжатия файлов с использованием LZ4 и CUDA показала неплохие результаты. Время сжатия действительно сократилось примерно на 20%, что, согласитесь, довольно неплохо. Это позволило мне понять, что для задач, где обработка больших массивов данных происходит параллельно, видеокарта может стать действительно эффективным инструментом. Я даже подумал о создании небольшого утилиты для быстрой обработки архивов, используя данный подход.

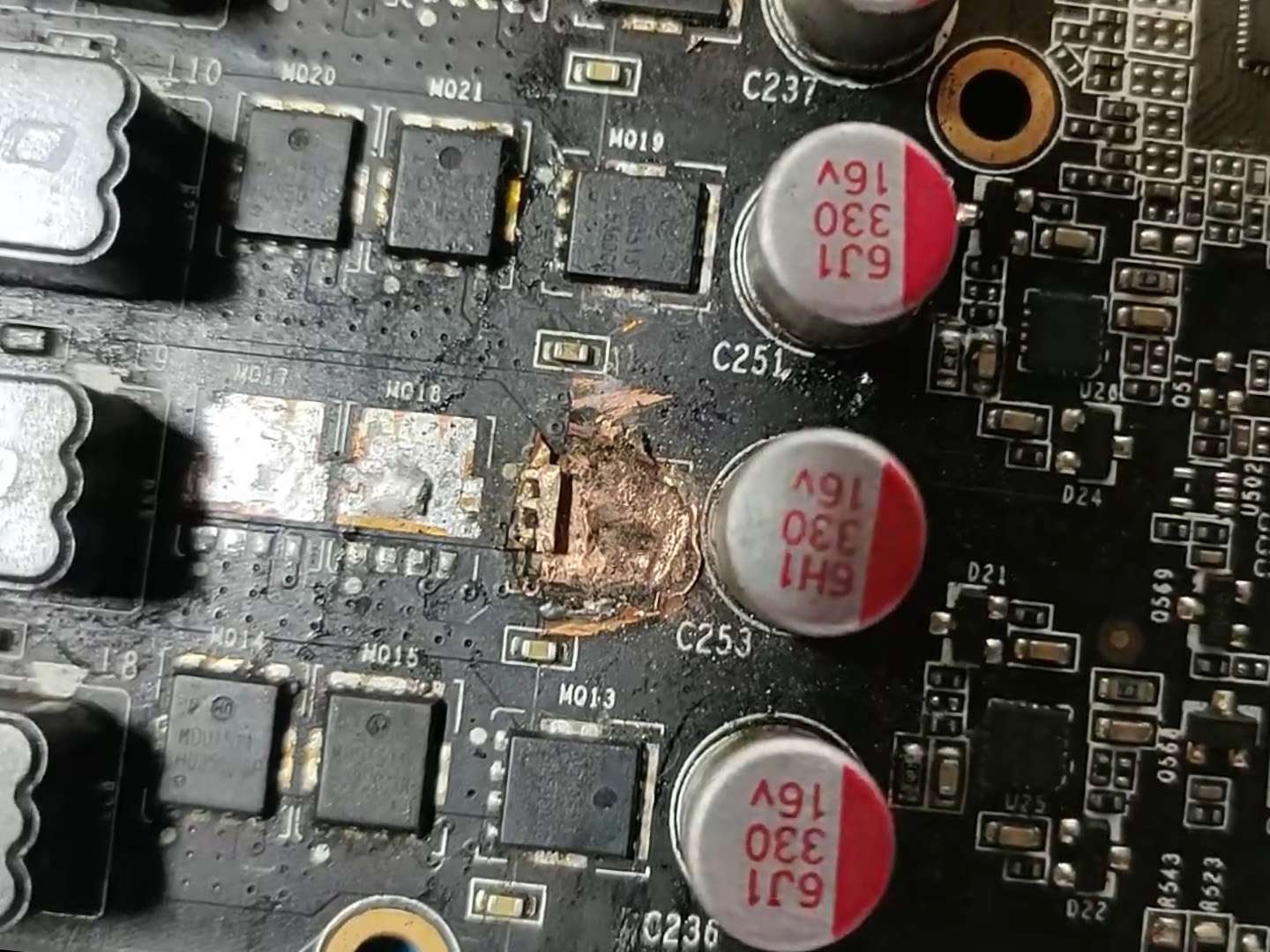

Однако, большинство моих попыток эмулировать процессорные задачи на видеокарте закончились провалом. Самой большой проблемой оказалась передача данных между процессором и видеокартой. Эта операция занимала значительно больше времени, чем сами вычисления на GPU. Даже при использовании оптимизированных библиотек и алгоритмов, я не смог избежать этого узкого места. В некоторых случаях время передачи данных превышало время выполнения задачи в десятки раз. Это делало использование GPU совершенно неэффективным.

Еще один фактор, который сильно повлиял на результаты, – это сложность программирования для GPU. Написание эффективного кода для видеокарты оказалось намного сложнее, чем для процессора. Требовалось глубокое понимание архитектуры GPU и особенностей параллельного программирования. Я потратил много времени на изучение OpenCL и CUDA, но даже после этого многие мои попытки оказались неуспешными.

Эксперименты с алгоритмами машинного обучения также не принесли желанных результатов. Сложность адаптации алгоритмов для работы на GPU, а также ограничения в объеме доступной памяти видеокарты предотвратили получение значимых результатов. В итоге, я пришел к выводу, что видеокарта – это мощный инструмент, но он не может полностью заменить процессор в большинстве случаев.

Анализ полученных данных и выводы о практической применимости

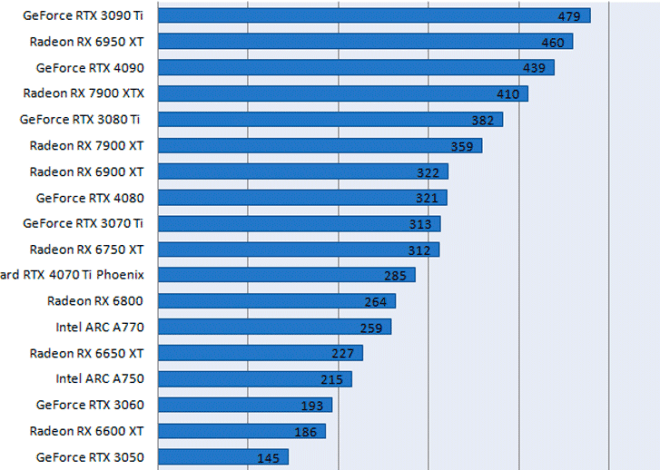

После завершения экспериментов и анализа полученных результатов, я пришел к нескольким важным выводам о практической применимости идеи замены процессора видеокартой. Главный вывод – прямая замена процессора видеокартой невозможна. Архитектура процессора и видеокарты принципиально различна. Процессор предназначен для выполнения широкого спектра задач, требующих гибкости и последовательной обработки данных. Видеокарта, напротив, оптимизирована для параллельной обработки больших массивов данных, что идеально подходит для задач, связанных с графикой, вычислениями в машинном обучении и некоторыми специфическими алгоритмами обработки информации.

Анализ данных показал, что эффективность использования видеокарты напрямую зависит от характера задачи. Задачи, которые легко распараллеливаются и не требуют сложного взаимодействия с другими компонентами системы, демонстрируют значительное ускорение при обработке на видеокарте. К таким задачам относятся, например, обработка изображений, кодирование/декодирование видео, и некоторые задачи из области научных вычислений. В этих случаях, выигрыш во времени обработки может быть весьма существенным.

Однако, для большинства стандартных задач, требующих последовательной обработки данных и постоянного взаимодействия с различными компонентами системы, использование видеокарты оказывается неэффективным. Высокая стоимость передачи данных между процессором и видеокартой, а также сложность перевода кода под архитектуру GPU делают такой подход нецелесообразным. Более того, многие системные вызовы и операции просто не могут быть эффективно реализованы на видеокарте.

Таким образом, я сделал вывод, что видеокарта не может полностью заменить процессор. Ее роль – это роль эффективного помощника, способного значительно ускорить выполнение специфических задач. Однако, для большинства пользователей и стандартных приложений, процессор остается незаменимым компонентом компьютерной системы. Более того, требуется глубокое понимание параллельного программирования и особенностей архитектуры GPU для эффективного использования видеокарты в вычислительных задачах.